文章目录

2025年1月20日,幻方量化旗下AI公司深度求索(DeepSeek)正式发布DeepSeek-R1推理模型,R1在AIME 2024、Codeforces、MMLU等数学竞赛、编程竞赛、通用知识理解与推理基准中媲美OpenAI o1,在全球引起轰动与关注。

R1采用纯强化学习就达成目标了性能对齐o1的结果,且完全开源。另外,R1的训练成本远低于OpenAI o系列和Google Gemini系列大模型,且R1提供了高性价比的API服务,对输入token收费为每百万0.55美元,输出token收费为每百万2.19美元,而OpenAI o1的两项费用分别为每百万15美元和每百万60美元,价格差距接近30倍。

本文将对DeepSeek-R1的技术报告进行解读,剖析其关键技术创新点,并检视其对产业与国际AI进展的影响。

1.DeepSeek-R1的影响力

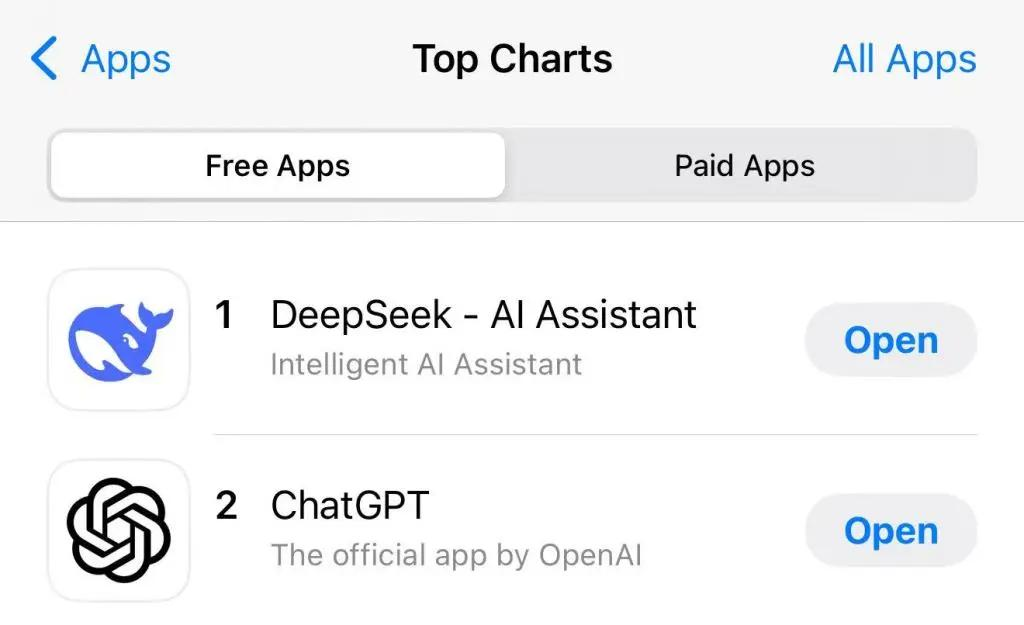

2025年1月27日,DeepSeek运用登顶苹果中国地区和美国地区运用商店免费APP下载排行榜,在美区下载榜上超越了ChatGPT,成为美国苹果运用商店下载量最大的免费运用程序。

另外,当日美国股市开盘即大幅下跌,科技板块尤为惨重。市场检视认为,核心背景是中国人工智能初创公司DeepSeek的最新突破,动摇了美国科技行业的“无敌”地位。

新宝全球在线app据CNBC检视,美国芯片巨头英伟达(NVIDIA)当日股价暴跌约17%,单日市值蒸发约6000亿美元,创美股单日下跌最高纪录。博通公司股价下跌17%,超威半导体公司(AMD)股价下跌6%,微软股价下跌2%。

2025年2月1日,DeepSeek月活跃用户数突破3000万,成为全球增速最快的AI运用之一。据AI产品榜,DeepSeek仅用7天达成目标了1亿用户增长,打破了ChatGPT的记录。

可以说此次DeepSeek的破圈程度不亚于3年前的ChatGPT。由于DeepSeek-R1是完全开源的[1],非技术人员也可以只通过几个简单步骤将其小规模参数蒸馏版本部署到本地电脑进行体验,这进一步降低了大模型的使用门槛。

图灵奖得主Yann LeCun承认R1的影响力和质量,表示新宝全球在线app这是开源的胜利。

可见,R1不仅在国内成为了流量最高的话题之一,也得到了国际顶级AI社区的认可,并且在金融圈也造成了非常大的影响,这对于长久在AI领域跟跑的中国AI企业来说是非常难得的。

2.DeepSeek-R1技术论文解读

与OpenAI o1不同,DeepSeek-R1直接开源了其模型参数,并且发布了技术论文。本文将对该技术论文中的主要贡献和创新点进行解读,不涉及公式推导。

下图为DeepSeek-R1技术论文的封面,从其标题可以看出,其最主要的工作是通过强化学习(Reinforcement Learning)来激发模型推理能力(Incentivizing Reasoning Capability),这也是R1最大的亮点之一。

由于OpenAI o1并未公布技术细节,我们只能从OpenAI此前发布的论文中推测其所采用的的技术。

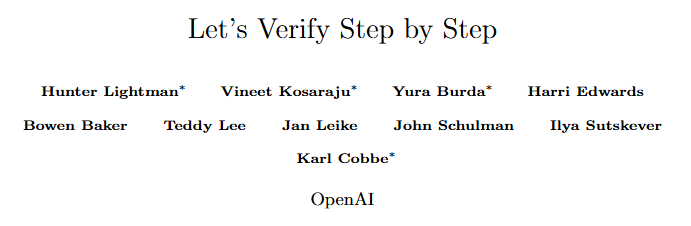

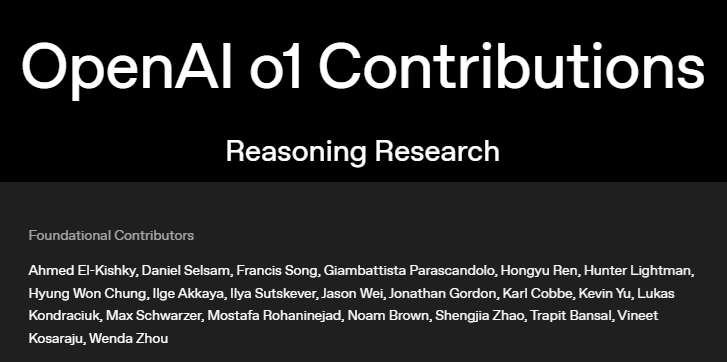

其中有一篇论文《Let’s Verify Step by Step》[2],其第一作者及多位作者均在o1核心贡献者名单中,如下图所示。

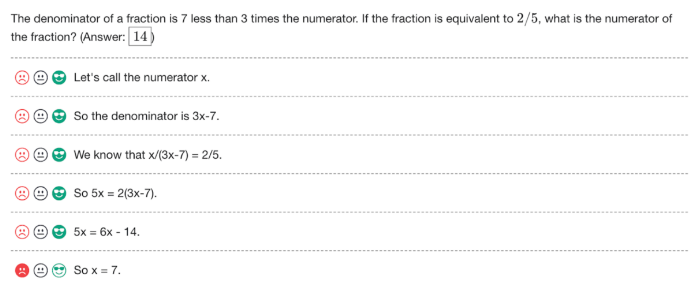

当时很多人认为这篇论文可能是o1复现的关键,该论文并没有提出新技术,而是重点试验了一种叫过程奖励模型(Process Reward Model,以下简称PRM)的技术,并公布了PRM800K资料集。

简单地说,PRM就是在模型训练时不只监督其推理影响(最后答案)是否正确,而是监督其每一步推理过程是否正确。其资料集格式如下图所示,对于每个障碍,其推理过程被分解为多个步骤,每一个步骤包含正确、中性、错误三种标签。

当时复现o1的工作主要可以分为两条路线:

1. 过程监督:也就是通过PRM,根据这些障碍、步骤及对应标签来指导模型训练,在模型进行错误推理时就指出错误,引导其进行正确推理,由此得到正确的答案;

2. 蒸馏:即利用已有的推理模型(如o1)来微调新的推理模型。

而DeepSeek-R1则探索了一条完全不同的道路,即纯强化学习。简单地说,也就是没有运用影响或过程神经奖励模型,只通过规则判断并告诉模型其生成的答案是否正确,让模型自己进行反思和改进。

DeepSeek在其技术论文中提出了三种模型,分别是DeepSeek-R1-Zero、DeepSeek-R1(在不另外说明的情况下,后文分别简称为R1-Zero和R1)和基于R1的蒸馏模型。

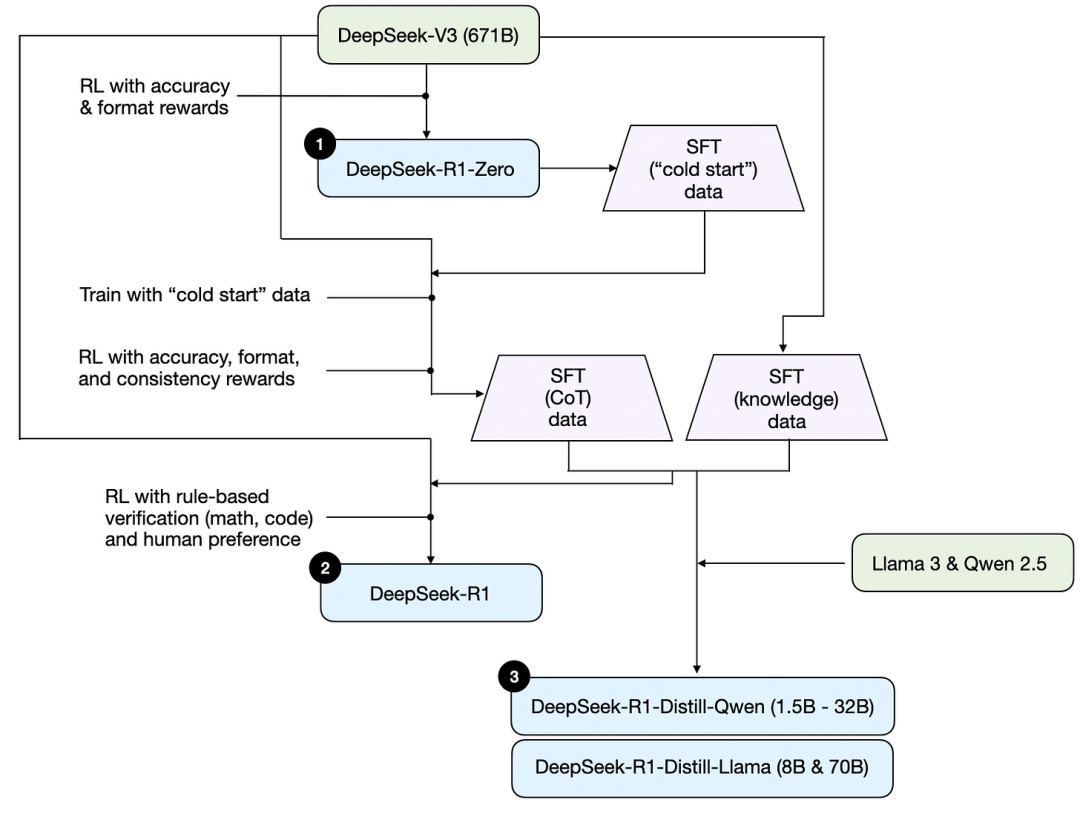

在解读这三种模型之前,我们先引用AI领域专家Sebastian Raschka的博文《Understanding Reasoning LLMs(理解推理大语言模型)》[3]中的一张图新宝全球在线app来帮助理解。

从上图中我们能够观察到,DeepSeek-R1-Zero由671B参数的DeepSeek-V3经过强化学习得到,DeepSeek-R1由前面两种模型经过冷启动(Cold start)和SFT(Supervised fine-tuning,监督微调)得到,而蒸馏版的R1则是用前面阶段生成的SFT资料来对Llama 3和Qwen 2.5系新宝全球在线app列模型进行微调得到,参数量在1.5B到70B之间(我们按照网上的教程用Ollama本地部署的大多是蒸馏模型)。

2.1

DeepSeek-R1-Zero

正如前面所提到的,DeepSeek-V3 + 强化学习 = R1-Zero。这也是令大多数技术人员感到最为神奇的地方,它实在是简单到令人难以置信。

R1-Zero通过下图形式的模板来进行强化学习训练。

模板也可以理解为系统的prompt,在用户输入障碍后,会首先要做的是将上图中红色的prompt替换为用户的障碍,随后新宝全球在线app再输入模型。

该模板要求模型做以下两件事:

1. 告诉模型这是用户(User)和助手(Assistant)的对话,用户提问后助手进行解答;

2. 在解答前,首先要做的是进行思考,并且将思考过程写在标签和标签之间,将答案放在标签和标签之间。

R1-Zero没有运用影响或过程神经奖励模型,而是直接设置规则来判断答案是否正确,并且设置了思考格式奖励,详细如下:

1.准确性奖励:如果模型回答正确则给新宝全球在线app予奖励。对具有确定影响新宝全球在线app的数学、物理等障碍,直接判断生成答案是否与标准答案一致;对代码障碍,使用编译器验证生成代码的正确性。由此可见,这一步所采用的资料大多是具有明确对错的数学、物理、代码障碍。

2.格式奖励:如果模型将思考过程置于和之间,则给予奖励。

也就是说,R1-Zero没有运用神经奖励模型,而只是验证最后答案新宝全球在线app是否正确、是否符合要求格式来进行强化学习。

另外,R1-Zero使用了DeepSeek团队2024年2月在DeepSeekMath[4]中提出的GRPO算法进行强化学习,而不是大模型训练常用的PPO算法。

关于GRPO和PPO的区别,我们可以参考DeepSeekMath论文中的示意图:

上图新宝全球在线app中,黄色模型表示要被训练的模型,蓝色模型表示参数固定、不训练的模型,策略模型(Policy Model)即被训练的推理模型;

参考模型(Reference Model)一般是训练前的初始模型,作为训练过程的参考,限制策略模型与初始模型差异不要过大;

奖励模型(Reward Model)即对策略模型的输出给予奖励或惩罚的模型,引导策略模型基于奖励或惩罚自我改进;

价值模型(Value Model)参数量通常与策略模型相当,主要用来平衡奖励模型的过度优化。

从图中可以发现,GRPO相比PPO,去除了价值模型(Value Model),这在训练时可以突出减小内存和算力开销。

去除价值模型后,GRPO的替代方案是让策略模型回答同一个障碍多次,并计算它们的平均奖励,用这个平均奖励来代替价值模型的输出。

简单地说,R1-Zero没有采用类似PRM800K这样的复杂推理资料集,而是做了以下三件事:

1. 设置训练模板;

2. 设置基于规则的准确性奖励和格式奖励;

3. 采用GRPO进行训练。

除了得到一个在多个推理基准上结果媲美o1(如上表所示)的模型,试验人员还发现了一些有趣的情况:

模型在训练过程中自发地进行更多的思考,而上面介绍的训练中做的三件事并不包括要求模型多思考。如下图所示,横轴是训练迭代的步数,纵轴是模型响应的平均长度(模型思考内容长度)。

另外,如下图红色部分字体所示,R1-Zero的某个中间版本学会了用拟人化的语气进行反思(模型:“等一下,等一下。这是一个我可以标记的顿悟时刻。”),这些自我验证都是在没有监督和奖励的情况下,模型自然学习到的。

尽管R1-Zero表现出强大的推理能力,它也有以下两个不足:

1.可读性差:ChatGPT或文心等大模型通常会输出精美的Markdown格式文新宝全球在线app本,用户对其内容一目了然,而R1-Zero也许是由于专注于推理,输出的可读性不如传统大模型;

2.多语言混杂:即模型输出混杂了各种语言,这也是推理模型的通病。

国外也有网友截图了OpenAI的o3的思考过程,发现用英语向o3提问,o3混杂了中文推理。甚至有国外网友截图并问Sam Altman是不是在蒸馏R1。

2.2

DeepSeek-R1

为了解决R1-Zero的缺点,DeepSeek团队对R1-Zero设计了一个冷启动+强化学习的训练方法,我们可以回顾一下前文出现过的训练流程图,并重点关注DeepSeek-R1的训练流程部分:

在这里,我们用中文及不同颜色加入了一些注解。在训练得到R1-Zero后,继续进行以下几个步骤:

1.冷启动:向R1-Zero提问并收集其包含思考过程的输出,用这些“问答对(Q&A Pairs)”来微调DeepSeek-V3,得到会思考的DeepSeek-V3;

2.第一次强化学习:新宝全球在线app与R1-Zero的训练过程基本相同,为了缓解语言混杂障碍,额外引入语言一致性奖励(例如:对中文障碍,模型输出的中文比重越多,可以得到越多奖励),得到语言一致的DeepSeek-V3。

3.SFT(监督微调):与冷启动类似,向第2步得到的具有语言一致性的模型提问并收集回答,并进行筛选,得到约60万条推理训练资料;另外,重用DeepSeek-V3的SFT资料,得到约20万条非推理(通用知识)训练资料,通过这约80万条资料重新训练初始DeepSeek-V3(而不是继续训练上一步的V3)。

4.第二次强化学习:主要是为了使模型回答更符合人类偏好,利用R1-Zero类似的基于规则的奖励来指导数学、代码等领域的训练,利用学习过人类偏好的奖励模型指导一般障碍的训练,旨在提高模型的可靠性和无害性,并得到最后的DeepSeek-R1。

如果说下围棋的AlphaGO Zero生成对抗训练像是左右手互搏的话,那么R1的训练过程新宝全球在线app就像是左脚踩右脚登天的“梯云纵”。先用DeepSeek-V3训练了会推理的R1-Zero,再用R1-Zero反哺V3得到说人话的R1。

2.3

蒸馏模型

除了R1-Zero和R1,DeepSeek团队还进行了蒸馏的试验。我们再回到之前的流程图,关注右下角深红色路径部分。

简单地说,这项工作就是用上面介绍的R1训练过程的第三步产生的资料来微调Llama、千问等模型。

这项工作主要是想验证没有经过纯强化学习的模型,能否通过直接学习R1输出的资料,来学会推理。实验影响如下表所示:

可以看到,经过R1的蒸馏后,无论是仅有1.5B的千问,还是70B的Llama,在各项推理基准上的性能都突出提升,甚至超过参数比它们大得多的GPT、Claude等大模型。

另外,DeepSeek团队还进行了一项对比实验,新宝全球在线app对32B的千问进行与R1-Zero相同的强化学习训练,与R1蒸馏的32B千问进行对比,如下表所示:

可以发现,强化学习版千问距蒸馏版千问有较大差距,这说明左脚踩右脚也是要有一定基础的。

这项工作印证了通过较大的推理模型产生的资料对小模型进行微调,无需强化学习,即可让小模型的表现拔地而起。

这也大大节约了训练成本,让大家可以在不用花上百万购买8张A100的情况下,在家中的电脑直接部署这些蒸馏模型,也是DeepSeek破圈的一个关键背景。

3.DeepSeek-R1的出圈之路

3.1

试错之路

通过上一节的检视,我们知道,R1主要走了纯强化学习的路线,这在以前鲜有团队尝试过。

大家都在从OpenAI o1的技术报告中进行各种检视,在PRM、蒸馏、MCTS(Monte Carlo Tree Search,蒙特卡洛树搜索)等各种方法间试错时,R1走了一条完全不同、非常大胆的路,并且成功了。除此以外,R1团队还大方公开了自己的发现。

当然,探索之路并非一帆风顺,R1团队也进行过以上尝试,但与大部分尝试复现o1的团队一样,都没有取得太大突破,他们也在技术报告中介绍了在PRM和MCTS上的不太成功的尝试。

PRM需要对推理过程进行步骤级别的划分和打分。利用模型自动打分准确率堪忧,而人工打分又不利于大规模强化学习。尽管PRM能带来一定提升,但这在资金和时间成本上是很难控制的。

MCTS被成功运用在AlphaGo中,并且也有团队尝试将MCTS运用在推理模型中。简单来说,MCTS是一种寻找最优决策的算法,通常运用于组合博弈中的行动规划。

围棋棋盘共有19*19*361个落子点,去除棋盘中已经落下的棋子,棋盘的落子空间(即每一步的选择空间)是有限的。

但在语言模型中,搜索空间是难以控制的。DeepSeek-R1的词表大约为15万,即每次生成一个token都需要在15万个词中进行搜索,并且句子长度也是不确定的。由此可见,MCTS在语言模型的优化中是具有障碍的。

3.2

技术积累

罗马不是一天建成的,DeepSeek团队在2024年2月发布DeepSeekMath、提出GRPO算法,在2024年5月发布DeepSeek V2[5],引入了DeepSeekMoE、MLA等优化训练方法,在2024年12月发布DeepSeek V3[6],引入FP8、MTP优化方法,最后将这些技术结合起来,才得到了轰动全球的R1。

3.2.1、DeepSeekMoE

DeepSeekMoE是对MoE(Mixture of Experts,混合专家模型)的改进。

MoE并不是一个新概念,但最近几年,一个欧洲的团队Mistral推出了MoE模型Mixtral-8x7B,其凭借较少的参数,表现出与Llama2 70B和GPT-3.5相当的性能,使得人们发现了MoE的价值。

Mixtral-8x7B具有46.7B的参数量,由8个专家模型组成,每输入一个词时,一个路由网络选择其中的2个专家进行处理方式,而不是将整个网络用于推理,这大大削减了模型推理的成本。

DeepSeek对MoE(上图(a))作了一些创新。在专家总参数量和计算开销不变的情况下,他们进行更细粒度的专家划分,扩大了专家数量(新宝全球在线app在DeepSeek MoE V3中,模型有多层,每层有256个“专家”)(上图(b))。

DeepSeek MoE不是简单地用路由网络将token分流给专家,而是在token被送往专家之前,加了几层FFN(一种简单的网络结构),能够理解潜在空间中的一些概念,通过扩大少量参数使得路由网络更高效地选择专家。

另外,DeepSeek还引入了共享专家的概念,即上图(c)中绿色区块。每一层无论选择了哪几位专家,共享专家是一定会被激活的,提供一些通用的处理方式能力。

MoE可以类比为医院的分诊台,病人挂号后被分配到不同的专家医师。而DeepSeek的创新则是安排了具有一定医学知识的“挂号专家”来代替传统MoE中不具备专业知识的普通职员来进行分流,并且细分科室,用更多的医生协同诊断。

3.2.2、MLA(Multi-head latent attention,多头潜在注意力)和FP8

MLA和FP8是偏算法的两个概念,也是降低训练成本的核心技术,在这里一起简单介绍,限于篇幅不作详细展开。

语言模型中Transformer的MHA(Multi-head attention,多头注意力)会占用很大的显存,主要用于存储上下文信息。

而MLA可以理解为用时间换空间,把高维矩阵压缩到低维的潜在空间。虽然训练时需要花更多的时间,但可以压缩尺寸,存储更多的上下文。

并且在测试中发现,MLA相比MHA智力性能没有下降,反而有提升。

FP8即8位浮点数,即用8位数来表示模型中的参数。而传统的模型通常用FP32或FP16,大家都认为FP8的精度不够。

但是DeepSeek将其成功运用到了大模型上,并且稳定性极为出色。这不但突出削减了计算和存储开销,也让我们能够在较低配置的设备上部署模型。

3.2.3、MTP(Multi-token prediction,多token预测)

对语言模型或Transformer有一定了解的读者应该知道,模型通常采用单token预测的方法来生成文本,即首先要做的是吐出第一个词,随后基于这个词再吐出第二个词,接着生成第三个词……直到生成结束符号来组成一个完整的回答。

一种新思路是在预测时与此同时推测多个token,也就是让模型在预测时候考虑地更长远,避免陷入局部最优,这也是MTP的基本原理。与此同时,由于一新宝全球在线app次可以生成多个token,MTP也带来效率的提升。在DeepSeek V3中,MTP具备一次生成两个token的能力。

4.DeepSeek-R1对业界和国际AI进展的影响

把上一节提到的优化算法放一起看,再结合当前国际形势,我们可以知道,所有这些优化都是为了缓解计算资源的紧张而出现的。

通过上图(来自互联网)对比可以发现,H800相比H100最主要的区别,在于NVLink互联带宽接近被腰斩。受相关政策影响,NVIDIA最先进的H100、A100等GPU我们无法买到,而只能购买“特供版”的H800、A800。

MoE、MLA、FP8、MTP、GRPO等所有试验,可以说都是为了降低新宝全球在线app运算量而进行的。在DeepSeek V2、V3、R1被最后训练出来之前,试验人员还要进行大量实验,如果没有这些优化算法的支撑,也许我们还要过几年才能看到R1。

对模型本身来说,R1最大的突破是它不亚于o1的性能。第二步是是它相对较低的训练成本,经历过PRM、MCTS的试错,绕过了算力封锁,通过一系列创新优化方法,闯出了一条完全不同的道路。最关键的是,它是开源、免费的。

o1是付费的,并且订阅价格并不便宜,所以尽管我们知道o1很擅长推理,很优秀,但我们可能并没有实际使用过它。而对标o1的R1可以通过网页或app免费使用,可以说是大部分人第一次真正使用的推理模型。

它的结果无需赘述,在勾选了“深度思考”和“联网搜索”并提问后,用户可以发现与平时使用的ChatGPT等大模型完全不同的体验,以致于OpenAI在2025年1月31日紧急上线了o3-mini,扩大了推理和联网搜索选项,并且每日开放一定的免费使用额度。

从技术革新角度来看,DeepSeek-R1探索了纯强化学习的训练路径,摒弃了几乎所有大模型都使用的监督微调,通过实验版本R1-Zero印证,无需人工标注资料,模型即可通过强化学习达成目标自我进化。更令人瞩目的是其成本优势和仅为o1的1/30的API价格,打破了闭源模型长久垄断的高价门槛。

从产业影响角度来看,DeepSeek-R1可能导致开源生态与商业化运用的双重加速。

R1不仅开源模型参数,也公开了其训练细节,目前已有不少成功的R1复现工作出现。这种透明性推动了开源社区的繁荣、技术社区的协作创新,改变了开源与闭源的竞新宝全球在线app争格局。

低价的API服务使企业能以更低预算开发AI运用,这或将提升众多中国企业在AI运用侧的竞争力。

经过蒸馏的小模型为手机、物联网设备等端侧部署提供了可能。1.5B的模型已能解决部分复杂数学障碍,这对教育、工业自动化等场景具有关键意义。

从国际竞争角度来看,DeepSeek-R1的出现印证了开源模式正在障碍闭源霸权。OpenAI、Google等美国公司长久主导AI技术的制高点,中国企业长久处在跟跑位置,DeepSeek-R1的出现标志着非美国企业首次在AI核心领域达成目标赶超。

OpenAI自ChatGPT发布起基本不再践行其早期的“开放AI”理念,而DeepSeek-R1的开源策略与OpenAI形成鲜明对比,打破了技术壁垒。

开源模型新宝全球在线app降低了发展中国家参与AI竞赛的门槛,全球AI研发重心或从“集中化”转向“分布式创新”,引起技术扩散与多极化。

未来AI竞争力可能不再仅依赖单一模型的性能,而是开源社区的活跃度、商业化运用的广度,以及技术落地的成本效率,生态竞争替代单点突破。

当然,开源与闭源并没有胜负之说,R1验证了开源模式在技术民主化、商业运用上的潜力,而闭源模型在资料隐私、定制化服务上仍有优势。两者结合或许可以催生混合模式模型,例如基础模型开源,而垂直领域对策闭源。

无论怎样,DeepSeek-R1的发布已为全球AI产业注入新变量:它不仅是技术的里程碑,更是一场关于“开放与封闭”、“普惠与垄断”的生态革命。

正如NVIDIA科学家Jim Fan所感慨的:“我们正生活在一个特殊的时代:一家非美国公司在真正践行着 OpenAI 最初的使命——开展真正开放的前沿试验,为所有人赋能。这看似不合常理,但最富戏剧性的往往最可能发生。”

参考文献:

[1]

[2]LIGHTMAN H, KOSARAJU V, BURDA Y, et al. Let’s Verify Step by Step[J].

[3]

[4]SHAO Z, WANG P, ZHU Q, et al. DeepSeekMath: Pushing the Limits of Mathematical Reasoning in Open Language Models[J].

[5]DeepSeek-AI. DeepSeek-V2: A Strong, Economical, and Efficient Mixture-of-Experts Language Model[EB/OL]. 2024.

[6]DeepSeek-AI, LIU A, FENG B, et al. DeepSeek-V3 Technical Report[J]. 2024.

END

供稿 |丁敏捷 陈敏刚

转载请注明来自必赢娱乐官网投注,本文标题:《合乐体育下注, 新宝全球在线app》

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号